Bom dia pessoal , como estão ? Quais as novidades por ai ?

@ibacaraujo descolou um grupo de estudos ? tu sumiu kra ! hehehe abraços

Olá, eu acabei de lançar um tópico de discussão sobre grupos de estudo da Fastai para coletar feedbacks dos organizadores e participantes, a fim de listar as melhores práticas e também para evitar algumas lacunas.

Você encontrará mais informações neste post. Obrigado se você puder participar da discussão

Ainda não existe uma categoria no fórum para agrupar as discussões relacionadas ao novo curso de NLP da Rachel:

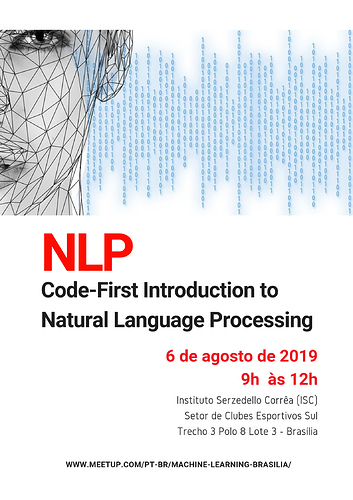

Considerando a estrutura do fórum e sua ampla comunidade de participantes, sugiro que as discussões sobre NLP associadas ao nosso curso presencial, em Brasília, iniciando terça-feira 6 de agosto de 2019, ocorram nessa thread.

Estamos lançando o primeiro curso de NLP organizado pelo grupo de estudo em Deep Learning de Brasília, baseado no curso da Rachel da fast.ai

Os encontros serão às terças pela manhã (9h às 12h) no ISC/TCU, iniciando na primeira terça-feira de agosto, 6/8/2019. Serão 8 encontros de 3h, voltado para programadores, com experiência em python e ML.

Como todos os cursos da fast.ai, esse de NLP também será extremamente prático e voltado para replicar resultados no estado da arte. Conteúdo:

Métodos tradicionais de NLP

Modelagem de Tópicos com SVD e NMF

Classificação de sentimentos com Naive Bayes e Regressão Logística

Derivação de Naive Bayes e Estabilidade Numérica

Revisitando Naive Bayes e Regex

Aprendizado Profundo (Deep Learning): Transferência de aprendizado para NLP

Introdução à modelagem de linguagem

Transferência de aprendizagem

ULMFit para idiomas não ingleses

Deep Learning: tradução Seq2Seq e o Transformer

Noções básicas sobre RNNs

Tradução com Seq2Seq

Algoritmos de geração de texto

Implementando uma GRU

Introdução ao Transformer

O Transformer para tradução de idiomas

Questões Éticas em NLP

Detalhes do curso da fast.ai: https://www.fast.ai/2019/07/08/fastai-nlp/

Peço ajuda para organizarmos essa thread do fórum para uso do curso.

Outro canal para dúvidas pode utilizar nosso grupo no Telegram t.me/DeepLearningBSB

Parabéns pela iniciativa Erick. Graças a seu esforço e dos demais colegas conseguiremos fortalecer a comunidade Brasileira e Sul-Americana.

Dicas do notebook 7 seq2seq:

Tem uma célula que explica a instação da biblioteca fastText do facebook, fiquem atentos pra versão do python que vcs tão usando se for a 3 tem que mudar o pip install que é utilizado pra ser o pip3 install.

E na importação na célula seguinte “import fastText as ft”, tive que deixar o “T” em minúsculo “import fasttext as ft”

Além disso não rodei a descompactação da forma como tá na célula gunzip {path} cc.en.300.bin.gz. Dei um ssh na máquina e rodei lá direto na pasta com gunzip cc.en.300.bin.gz.

E também tive que criar a pasta Models pq no ambiente ela não existia antes de salvar os arquivos ‘fr_emb.pth’ e ‘en_emb.pth’ com o comando os.makedirs(model_path,exist_ok=True).

Em diversos notebooks apresentados no vídeo “ULMFit for non-English Languages (NLP Video 10)”, aparece a linha a seguir:

lr *= bs/48

Onde “lr” representa o valor do hiperparâmetro “learning rate” e “bs” representa o valor do “batch size”.

Pesquisando um pouco, encontrei uma explicação plausível para essa vinculação hiperparamétrica:

Quanto “bs” diminui (acarretando maior regularização), “lr” deve diminuir (provocando menor regularização). Isso ajuda a equilibrar o efeito de regularização do modelo após mudanças dos hiperparâmetros.

“It is often better to use a larger batch size so a larger learning rate can be used”

Sou aqui do Rio e gostaria de participar de algum grupo também. Alguém próximo já está em um?

Would the proposed study group communicate in Portuguese or in English?

Boa tarde, existe algum canal de comunicação ativo em lingua portuguesa para entusiastas do fast.ai? Adoraria participar